Diversi ricercatori universitari stanno suonando campanelli d’allarme per la nuova tecnologia che verrà utilizzata da Apple per scansionare le librerie foto degli utenti e trovare eventuali immagini pedopornografiche inserite nel database CSAM.

Secondo i ricercatori, questa tecnologia sarebbe pericolosa perché ci sono seri rischi per la privacy degli utenti. I ricercatori hanno avviato un progetto due anni fa per identificare il CSAM nei servizi online crittografati end-to-end e oggi fanno notare che, dato il loro campo, “conoscono il valore della crittografia end-to-end, che protegge i dati dall’accesso di terze parti“. Questa preoccupazione, dicono, è ciò che li inorridisce per la “proliferazione di CSAM su piattaforme crittografate“.

Jonanath Mayer e Anunay Kulshrestha vorrebbero trovare una via di mezzo per risolvere la situazione: costruire un sistema che le piattaforme online possano utilizzare per trovare CSAM e proteggere la crittografia end-to-end. I ricercatori osservano che gli esperti del settore dubitavano della prospettiva di un tale sistema, ma sono riusciti a costruirlo e nel processo hanno notato un problema significativo.

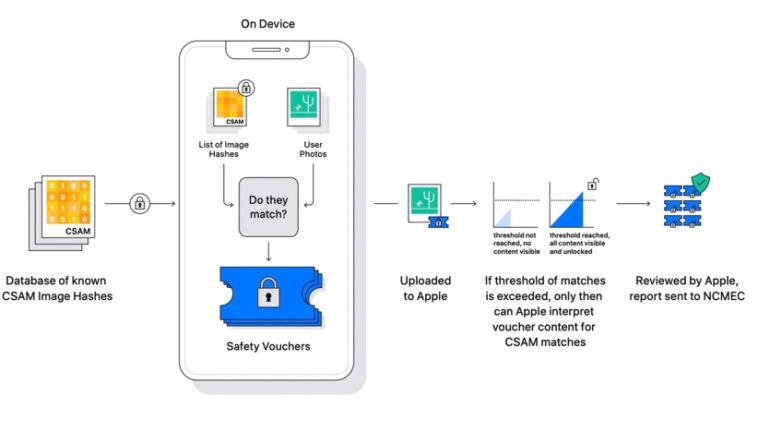

Abbiamo cercato di esplorare una possibile via di mezzo, in cui i servizi online potessero identificare i contenuti dannosi preservando al tempo stesso la crittografia end-to-end. Il concetto era semplice: se qualcuno condivideva materiale che corrispondeva a un database di contenuti nocivi noti, il servizio veniva avvisato. Se una persona condividesse contenuti innocenti, il servizio non effettuava alcuna operazione. Le persone non potevano leggere il database o sapere se i contenuti corrispondevano, poiché tali informazioni potrebbero rivelare metodi di applicazione della legge e aiutare i criminali a eludere il rilevamento.

Osservatori esperti sostenevano che un sistema come il nostro fosse tutt’altro che fattibile. Dopo molte false partenze, abbiamo costruito un prototipo funzionante. Ma abbiamo riscontrato un problema evidente.

Dall’annuncio della funzionalità da parte di Apple, la società è stata bombardata di critiche per il fatto che il sistema dietro il rilevamento di CSAM potesse essere utilizzato per rilevare altre forme di foto su richiesta di governi oppressivi. Apple ha fortemente respinto tale possibilità, affermando che rifiuterà qualsiasi richiesta del genere da parte dei governi.

Tuttavia, sono diffuse le preoccupazioni sulle implicazioni future della tecnologia utilizzata per il rilevamento di CSAM. Mayer e Kulshrestha hanno affermato che le loro preoccupazioni riguardano come i governi potrebbero utilizzare il sistema per rilevare contenuti diversi da CSAM.

Un governo straniero potrebbe, ad esempio, imporre un servizio a persone che condividono un discorso politico sfavorevole. Non è un’ipotesi: WeChat, la popolare app di messaggistica cinese, utilizza già la corrispondenza dei contenuti per identificare il materiale dissidente. L’India ha emanato regole quest’anno che potrebbero richiedere il pre-screening dei contenuti critici della politica del governo. La Russia ha recentemente multato Google, Facebook e Twitter per non aver rimosso i materiali di protesta a favore della democrazia.

Abbiamo individuato altre carenze. Il processo di corrispondenza dei contenuti potrebbe avere falsi positivi e gli utenti malintenzionati potrebbero ingannare il sistema per sottoporre a controllo gli utenti innocenti.

Eravamo così turbati che abbiamo fatto un passo che non avevamo mai visto prima nella letteratura informatica: abbiamo messo in guardia contro la progettazione del nostro sistema, sollecitando ulteriori ricerche su come mitigare i gravi svantaggi.

Apple ha continuato a rispondere alle preoccupazioni degli utenti sui suoi piani, pubblicando documenti aggiuntivi e una pagina di domande frequenti per rassicurare tutti.

Da alcuni documenti interni inviati dal responsabile antifrode di Apple nei primi mesi del 2020 emerge anche che la società sapeva di avere un problema con la distribuzione di pornografia infantile sulle piattaforme iCloud e iMessage. Paradossalmente, faceva notare il dirigente, l’elevata attenzione di Apple nel proteggere la privacy degli utenti ha fatto in modo che molti sfruttassero questo vantaggio per condividere materiali illegali.

Proprio da queste preoccupazioni è nata l’idea di creare un sistema in grado di controllare e monitorare solo quelle foto che corrispondono ai materiali pedopornografici presenti nel database CSAM.

News