Apple continua a spingere sull’acceleratore dell’intelligenza artificiale. In un nuovo studio pubblicato su arXiv, i ricercatori dell’azienda, in collaborazione con la Ohio State University, hanno presentato FS-DFM (Few-Step Discrete Flow-Matching), un modello linguistico che può scrivere testi lunghi fino a 128 volte più velocemente rispetto ai modelli tradizionali come ChatGPT o Gemini.

La scoperta rappresenta un passo avanti importante nel campo dell’AI generativa, con implicazioni enormi per applicazioni di scrittura, assistenti digitali e futuri modelli Apple Intelligence.

Per capire la portata di FS-DFM, bisogna prima distinguere i diversi tipi di modelli di linguaggio:

- LLM autoregressivi (come ChatGPT o Gemini): generano testo un token alla volta, prendendo in considerazione il prompt e tutte le parole già scritte. Sono precisi ma lenti.

- Modelli di diffusione: producono molti token in parallelo, raffinando il testo in più passaggi. Sono più veloci, ma richiedono centinaia di iterazioni per raggiungere la qualità desiderata.

- Modelli flow-matching: eliminano il processo iterativo e puntano direttamente al risultato finale in un unico passaggio di apprendimento.

FS-DFM combina i vantaggi di questi approcci: pochi passaggi, alta qualità, tempi di generazione record. Nel dettaglio, FS-DFM genera testi completi in solo otto passaggi di raffinamento, mantenendo una qualità paragonabile a quella dei modelli di diffusione che ne richiedono oltre mille.

I ricercatori spiegano che il modello è stato addestrato con un approccio in tre fasi:

- Allenamento multi-budget: FS-DFM impara a gestire diversi numeri di iterazioni di raffinamento, adattandosi alla complessità del testo.

- “Teacher guidance”: un modello guida aiuta FS-DFM a fare aggiornamenti più precisi e ampi in ogni passaggio, senza deviare troppo dal testo desiderato.

- Ottimizzazione iterativa: ogni fase è calibrata per produrre risultati più stabili e coerenti con meno passaggi.

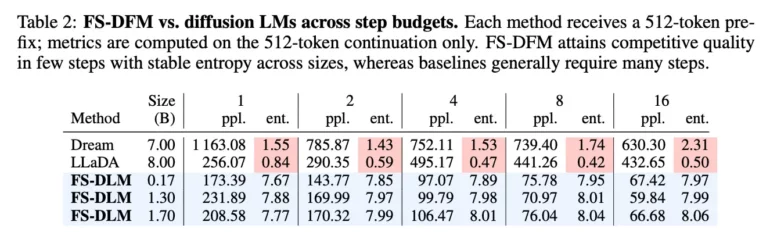

Il risultato è un sistema che mantiene la naturalezza del linguaggio (bassa perplexity) e sceglie le parole con coerenza e varietà equilibrata (entropia stabile). Nei test condotti dai ricercatori, FS-DFM ha superato modelli molto più grandi come Dream Diffusion (7B) e LLaDA (8B), pur avendo versioni con appena 0,17-1,7 miliardi di parametri.

In pratica, un modello più piccolo e leggero, ma con risultati migliori in qualità e velocità. Questo significa che in futuro Apple potrebbe eseguire AI complesse direttamente sui suoi chip, senza dipendere costantemente dal cloud.

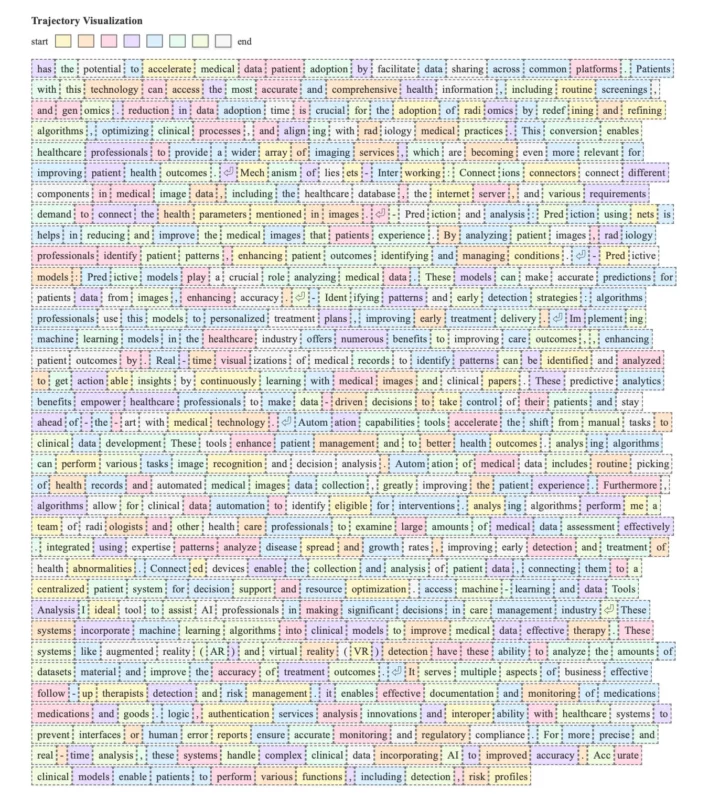

Il paper include anche una visualizzazione affascinante: ogni parola generata è colorata in base al momento in cui è stata stabilizzata durante le iterazioni, mostrando come il testo “prende forma” in tempo reale.

Il progetto FS-DFM non è solo un esercizio accademico. Si inserisce perfettamente nella strategia Apple Intelligence, dove l’obiettivo è portare AI potenti, ma efficienti, direttamente su iPhone, iPad e Mac.

Grazie a questo tipo di innovazioni, Apple può sviluppare modelli che scrivono, riassumono e rispondono in modo naturale e quasi istantaneo, senza compromettere privacy e performance.