Apple presenta UniGen 1.5, il nuovo modello di intelligenza artificiale capace di comprendere immagini, crearle da zero e modificarle all’interno di un unico sistema unificato. Un approccio che, nel panorama attuale dell’AI, rappresenta ancora una sfida complessa e che racconta molto della direzione che Apple sta prendendo nel campo dell’intelligenza artificiale multimodale.

La ricerca è stata pubblicata in un paper intitolato UniGen-1.5: Enhancing Image Generation and Editing through Reward Unification in Reinforcement Learning e si inserisce nel solco di lavori precedenti come UniGen, già presentato nel 2025. Ma qui il salto qualitativo è evidente: non si parla più solo di capire e generare immagini, bensì anche di modificarle in modo coerente seguendo istruzioni complesse, senza dover ricorrere a modelli separati.

UniGen 1.5 e la strategia Apple sull’AI multimodale

Negli ultimi mesi abbiamo visto Apple parlare sempre più apertamente di Apple Intelligence, ma sul fronte della ricerca pura l’azienda resta molto attiva, come dimostrano i lavori pubblicati su arXiv e citati da testate internazionali come MIT Technology Review e The Verge. UniGen 1.5 si inserisce perfettamente in questo contesto: un modello che tenta di superare la frammentazione tipica dei sistemi attuali, dove comprensione, generazione ed editing delle immagini vengono gestiti da architetture diverse.

Apple parte da un presupposto chiaro: un modello che capisce davvero un’immagine è anche più bravo a crearla e modificarla. Sembra banale, ma a livello tecnico non lo è affatto. Comprendere un’immagine richiede rappresentazioni semantiche profonde, mentre generarne una implica il controllo fine di dettagli visivi, stile e coerenza. Mettere tutto insieme, senza sacrificare qualità, è uno dei problemi più difficili dell’AI moderna.

L’editing delle immagini come vera sfida

Uno dei punti più interessanti di UniGen 1.5 riguarda l’image editing, cioè la capacità di prendere un’immagine esistente e modificarla seguendo istruzioni testuali anche molto specifiche. È qui che molti modelli, inclusi quelli più avanzati, mostrano i propri limiti. Le modifiche sottili, i cambiamenti localizzati o le richieste complesse spesso vengono interpretate male o applicate in modo impreciso.

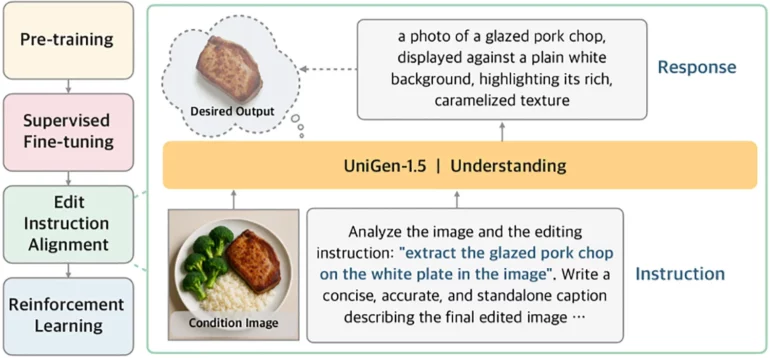

Apple affronta il problema introducendo una fase aggiuntiva chiamata Edit Instruction Alignment. In pratica, prima ancora di chiedere al modello di produrre l’immagine finale, UniGen 1.5 viene addestrato a generare una descrizione testuale dettagliata di come dovrebbe apparire l’immagine modificata, partendo dall’immagine originale e dalle istruzioni ricevute. Questo passaggio intermedio aiuta il modello a interiorizzare meglio l’intento dell’utente, riducendo ambiguità e interpretazioni errate.

È una soluzione elegante e, a giudicare dai risultati, efficace. Apple mostra come questa fase migliori sensibilmente le prestazioni nei benchmark dedicati all’editing, un ambito in cui anche modelli molto noti faticano ancora.

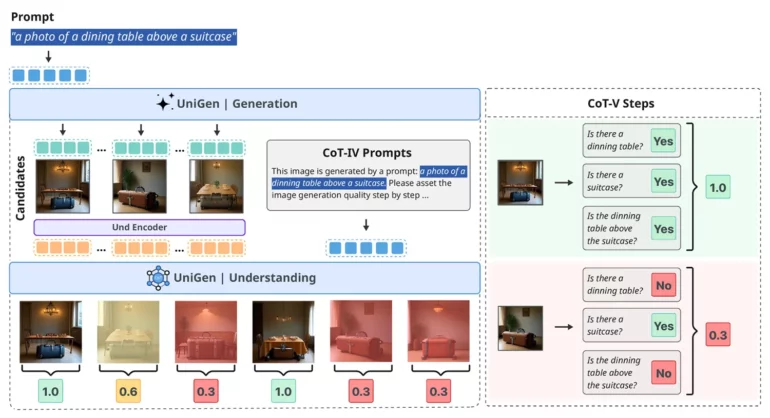

Un altro elemento chiave del paper riguarda l’uso del reinforcement learning. Tradizionalmente, generazione ed editing richiedono criteri di valutazione diversi, perché un’“ottima modifica” può essere un cambiamento minimo o una trasformazione radicale. UniGen 1.5 supera questo limite adottando un sistema di ricompense unificato, valido sia per la creazione di nuove immagini sia per l’editing di quelle esistenti.

Questa scelta consente al modello di mantenere coerenza visiva e fedeltà alle istruzioni in un ventaglio molto ampio di scenari. Nei test su benchmark riconosciuti a livello industriale, UniGen 1.5 non solo tiene testa a modelli open source avanzati, ma in alcuni casi eguaglia o supera soluzioni proprietarie. Parliamo di punteggi molto elevati su metriche come GenEval, DPG-Bench e ImgEdit, dove il modello di Apple dimostra una solidità sorprendente.

Limiti attuali e margini di miglioramento

Come ogni ricerca seria, anche questa non nasconde i propri limiti. UniGen 1.5 mostra ancora difficoltà nella generazione di testo all’interno delle immagini, un problema noto anche in altri modelli di riferimento. Inoltre, in alcuni casi emergono leggere incoerenze di identità, ad esempio nei dettagli di volti o texture, soprattutto quando l’editing è molto delicato.

Apple riconosce apertamente queste criticità e le considera aree di lavoro future. Ed è proprio questa trasparenza che rende il progetto interessante: non è un prodotto finito, ma una base solida su cui costruire.

Cosa significa davvero UniGen 1.5 per il futuro di Apple

UniGen 1.5 non è un annuncio di prodotto, non è una funzione pronta per iOS o macOS. È però un segnale fortissimo. Apple sta costruendo modelli multimodali proprietari, capaci di competere con i migliori sistemi sul mercato, ma con una filosofia diversa: meno frammentazione, più integrazione.

È facile immaginare come ricerche di questo tipo possano, nel tempo, confluire in strumenti creativi su iPhone, iPad e Mac, magari all’interno di Apple Intelligence, Photos, Final Cut o applicazioni ancora da immaginare. Un unico modello che comprende davvero ciò che vede potrebbe rendere l’editing fotografico, la creazione grafica e persino la realtà aumentata molto più naturali.