Anche se il lancio del sistema Child Sexual Abuse Material (CSAM) di Apple verrà ritardato, negli Stati Uniti continuano le critiche contro quella che viene definita una tecnologia molto pericolosa e controversa, malgrado la buona intenzione di rilevare immagini di abusi sessuali su minori.

Alcuni esperti di sicurezza informatica si sono opposti alla tecnologia CSAM di Apple pensata per limitare la condivisione di immagini pedopornografiche su iPhone e iPad. La critica arriva in un nuovo studio di 46 pagine che ha esaminato i piani di Apple e dell’Unione Europea per monitorare i telefoni delle persone alla ricerca di materiale illecito e ha definito questi sforzi come delle strategie inefficaci e pericolose che potrebbero incoraggiare la sorveglianza del governo.

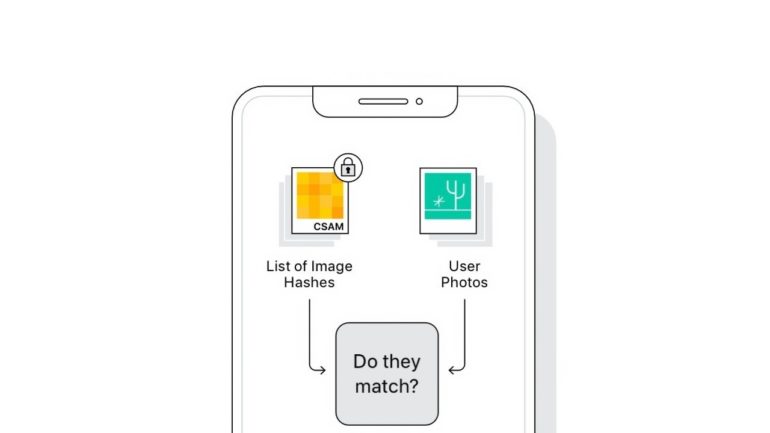

Annunciate ad agosto, le funzionalità pianificate da Apple includono la scansione lato client (ovvero sul dispositivo) delle librerie di foto di iCloud degli utenti per le immagini relative a materiale sessuale su minori (CSAM), così da poter avvisare per tempo le autorità competenti.

Secondo i ricercatori, questo sistema rischia di dare una finestra sui nostri iPhone ai governi di tutto il mondo, che potrebbero iniziare a spiare anche i cittadini rispettosi della legge. Apple ha fortemente respinto tale possibilità, affermando che rifiuterà qualsiasi richiesta del genere da parte dei governi. Ma per i ricercatori questo non basa.

A parte i problemi di controllo e sorveglianza, dallo studio emerge anche che la tecnologia non è efficace nell’identificare le immagini di abusi sessuali su minori, visto che bastano poche modifiche sulle foto per rendere questo controllo inefficace.

Il sistema CSAM consente la scansione di un dispositivo privato personale senza alcun motivo legato ad azioni illegittime. È straordinariamente pericoloso. È pericoloso per gli affari, la sicurezza nazionale, la sicurezza pubblica e la privacy.

Apple ha più volte ribadito che il suo sistema rispetta la privacy ed effettua un controllo in locale solo quando vengono rilevate immagini di questo tipo.