Apple ha eliminato tutti i riferimenti al rilevamento CSAM sulla pagina web Child Safety, suggerendo l’intenzione di abbandonare questa controversa funzione che avrebbe rilevato immagini di abusi sessuali su minori presenti sugli iPhone e gli iPad degli utenti.

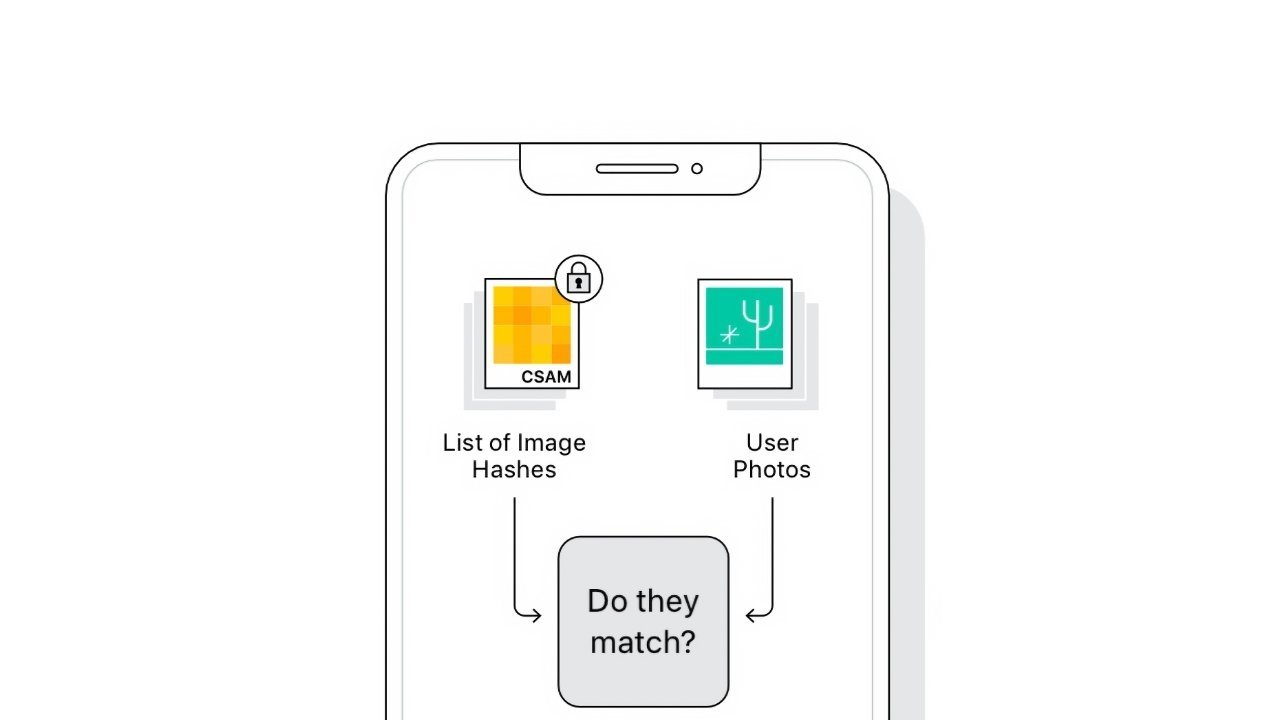

Annunciate ad agosto, le funzionalità CSAM pianificate da Apple includono la scansione lato client (ovvero sul dispositivo) delle librerie di foto di iCloud degli utenti per le immagini relative a materiale sessuale su minori (CSAM), così da poter avvisare per tempo le autorità competenti. Secondo i critici, questo sistema rischia di dare una finestra sui nostri iPhone ai governi di tutto il mondo, che potrebbero iniziare a spiare anche i cittadini rispettosi della legge. Apple ha fortemente respinto tale possibilità, affermando che rifiuterà qualsiasi richiesta del genere da parte dei governi. Ma per i ricercatori questo non basa.

Malgrado le rassicurazioni, non sono mancate ulteriori critiche, tanto che Apple ha ora deciso di eliminare i riferimenti alla tecnologia CSAM sul suo sito Web Child Safery. Tra l’altro, su iOS 15.2 sono state aggiunte funzioni che consentono all’app Messaggi di rilevare la presenza di nudità nelle immagini inviate ai bambini, ma non ci sono riferimenti alla tecnologia CSAM.

Con questa nuova mossa, non sappiamo se Apple si limiterà solo a ritardarne il lancio o se ha deciso di sospendere del tutto l’iniziativa.