La Electronic Frontier Foundation ha risposto favorevolmente alla decisione presa da Apple di ritardare il lancio dei tool CSAM, ma il gruppo vorrebbe di più e chiede all’azienda di rinunciare completamente a questa funzione.

Il 3 settembre, Apple ha annunciato che avrebbe preso più tempo per rivedere i suoi piani relativi al lancio delle funzionalità di protezione dei bambini, con l’obiettivo di migliorare gli strumenti e implementarli entro pochi mesi. In risposta, l’EFF crede che Apple dovrebbe fare ancora di più.

In una dichiarazione rilasciata nei giorni scorsi, il gruppo per i diritti digitali si è detto contento che Apple stia ora ascoltando le preoccupazioni dei suoi utenti sui pericoli posti dagli strumenti di scansione del telefono. Tuttavia, Apple “deve andare oltre il semplice ascolto e abbandonare completamente i suoi piani che prevedono di inserire una backdoor nella sua crittografia“.

La posizione del gruppo riassume le critiche che Apple ha ricevuto da oltre 90 organizzazioni in tutto il mondo, che hanno chiesto all’azienda di non implementare le funzionalità CSAM. Secondo queste organizzazioni, lo strumento potrebbe portare alla censura, alla violazione della privacy e a problemi di sicurezza per le persone in tutto il mondo, con “conseguenze disastrose per molti bambini“.

Resta da vedere quali modifiche Apple apporterà alle sue funzionalità CSAM, ma dato che si sta aprendo alla collaborazione, siamo sicuri che verranno apportate diverse modifiche.

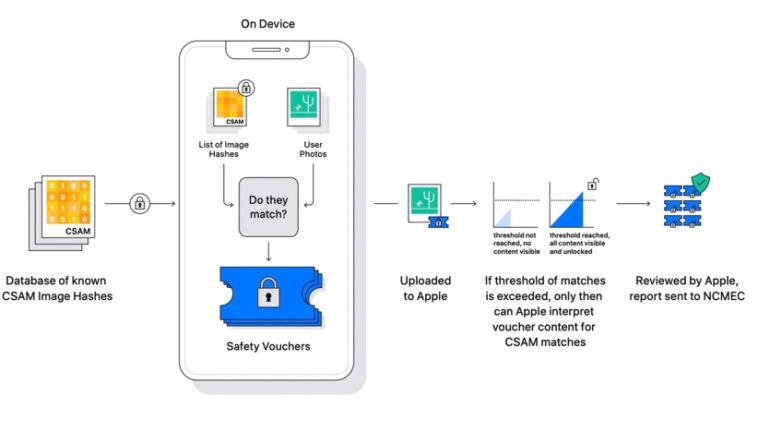

Apple ha più volte spiegato che la scansione CSAM non analizzerà le foto di tutte le persone sui loro iPhone, ma solo quelle i cui hash combaciano con le immagini pedopornografiche del database CSAM. Non solo, la società ha annunciato la scorsa settimana che il sistema potrà essere verificato anche da terze parti. Inoltre, Apple ha anche confermato che il rilevamento CSAM si applica solo alle foto archiviate in iCloud Photos, e non ai video.