Apple condivide nuove informazioni sul Foundation Models, un framework pensato per portare funzioni generative e di comprensione del linguaggio direttamente on-device dentro le app, con un’attenzione maniacale a privacy, latenza e affidabilità del risultato.

Con iOS 26, iPadOS 26 e macOS 26, non parliamo più di demo: parliamo di prodotti reali che iniziano a usare il modello locale da 3 miliardi di parametri, integrato in Swift, con tool calling e generazione guidata per risposte coerenti e strutturate. Tradotto: meno chiacchiere, più valore nell’app che apri ogni mattina.

Che cos’è Foundation Models

È un tessuto connettivo tra un’app e un LLM on-device ottimizzato da Apple. Non serve un server esterno, non servono chiavi API da gestire, non servono costi di inferenza. L’app invia una richiesta (prompt) al modello locale, può fornirgli strumenti (le funzioni dell’app, dati strutturati, knowledge base), e riceve una risposta controllata dal meccanismo di generazione guidata, che riduce ambiguità e allucinazioni. Il tutto offline quando possibile e con i dati che non lasciano il dispositivo.

Le prima app sullo store

Ci sono app che hanno già integrato questa novita:

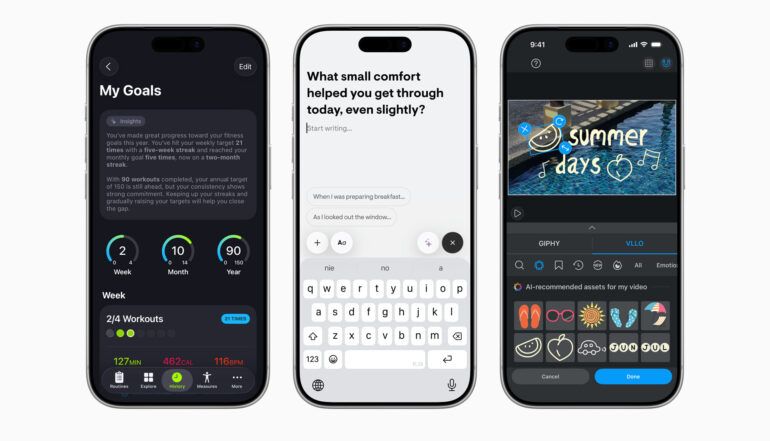

- SmartGym prende una descrizione naturale del tuo allenamento e la traduce in una routine completa con serie, ripetizioni e recuperi, adattandosi agli attrezzi disponibili e ai progressi. La parte interessante non è solo il piano, ma le spiegazioni: il sistema giustifica perché ti propone di cambiare carico o aumentare il riposo. Finita la sessione, genera un riepilogo leggibile con evidenza dei trend mensili.

- Stoic usa il modello locale per capire il tono delle tue note e proporti spunti personalizzati: se scrivi di aver dormito male trovi un prompt empatico, se annoti stress lavorativo arrivano riflessioni mirate. E lo fa on-device, quindi senza esporre contenuti intimi al cloud. In più, organizza le voci, crea riassunti e migliora la ricerca con linguaggio naturale.

- VLLO, editor video, legge la scena in anteprima (qui gioca anche Vision) e propone musiche e sticker dinamici coerenti con il contesto, abbassando l’attrito tipico dell’editing per chi è alle prime armi. Meno tempo in timeline, più tempo a pubblicare.

- Sul fronte didattico, CellWalk trasforma termini ostici di biologia in spiegazioni colloquiali ancorate ai contenuti certificati dell’app (grazie al tool calling che richiama le fonti interne). Imposti il profilo e il registro si adegua: linguaggio, profondità, collegamenti. È come avere un tutor che parte sempre dal tuo livello.

- E ancora: Grammo genera esercizi di grammatica inglese su misura, Lil Artist confeziona storie illustrate con scelte guidate a misura di bambino, Stuff converte parlato e scarabocchi in to-do puliti (“Ascolta”, “Scansiona” e capisce date, tag e scadenze), OmniFocus 4 propone progetti e next step a partire da un obiettivo (“viaggio a Lisbona”) con suggerimenti di tag e checklist sensate. L’elenco è lungo e cresce.

Cosa cambia per chi sviluppa

Non è solo un tema etico. Tenere tutto sul dispositivo significa latenza minima, affidabilità costante (niente endpoint esterni che cambiano), e soprattutto contestualità: il modello vede quel che deve vedere, nel formato giusto, al momento giusto. E con la generazione guidata l’app definisce come deve rispondere: JSON, testo strutturato, azioni. Niente sorprese.

Foundation Models si innesta in Swift come qualsiasi altro framework. Prepari il prompt, definisci eventuali strumenti (funzioni invocabili dal modello: cerca, calcola, recupera dati), e specifichi il formato di uscita. Il modello locale da 3B fa il resto. Niente GPU in cloud da pagare a consumo, niente coda di richieste, niente problemi di compliance perché i dati restano localmente. E se il modello ha bisogno di dettagli, li chiede tramite tool calling, che riporta l’LLM dentro i confini della tua app, non il contrario.

Il bello è che le funzioni spariscono nella UX. Pianifichi, scrivi, monti, studi: ti sembra uguale a ieri, ma è tutto più vicino al tuo contesto. Un riepilogo che ha senso per te, non per un utente generico. Un consiglio che rispetta i tuoi limiti fisici. Un promemoria che nasce da ciò che hai scritto mezz’ora prima. L’intelligenza non come chatbot a lato, ma come tessuto dell’interfaccia.

Due aspetti faranno la differenza in futuro. Primo: qualità delle integrazioni. Il framework è potente, ma a emergere saranno le app che curano i prompt, danno strumenti giusti al modello e costruiscono metriche di qualità sulle risposte. Secondo: coerenza cross-piattaforma. Con macOS 26 nella partita, i flussi che partono su iPhone e atterrano su Mac possono diventare realmente continui. Qui c’è spazio per un salto di qualità nell’ecosistema.

E per gli utenti finali?

Se un’app che usi spesso “ha preso vita” dopo l’aggiornamento, non è magia: è Foundation Models che lavora sotto traccia. Verifica sempre la sezione privacy dell’app e le impostazioni delle nuove funzioni intelligenti: puoi decidere quanto contesto dare e cosa automatizzare. E ricorda che molte di queste capacità funzionano anche offline.