Apple ha pubblicato un nuovo articolo sul suo Machine Learning Journal dedicato agli sviluppatori. Il nuovo post si concentra sul rilevamento del volto e sul framework Vision.

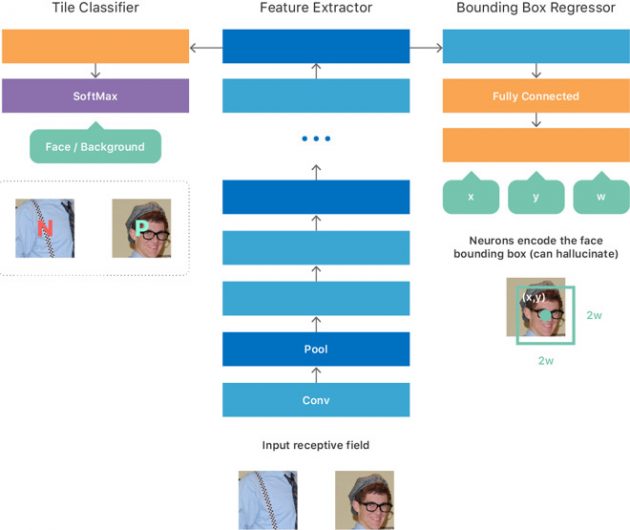

L’articolo si intitola “On-device Deep Neural Network for Face Detection” e parla nel dettaglio di come viene gestito il framework Vision e quali sono gli elementi che impediscono di farlo funzionare. Apple specifica che il rilevamento del volto salva i dati solo in locale e non in server: “I modelli di deep learning devono essere inviati come parte del sistema operativo, occupando spazio di archiviazione NAND. Devono anche essere caricati nella RAM e richiedono un tempo di calcolo significativo sulla GPU e/o CPU. A differenza dei servizi basati su cloud, le cui risorse possono essere dedicate esclusivamente ad una singola rilevazione, il calcolo sul dispositivo deve avvenire durante la condivisione di queste risorse con altre app in esecuzione. Inoltre, il calcolo dee essere sufficientemente efficiente da poter elaborare una grande libreria Foto in un tempo breve, senza dover spendere troppa energia o far aumentare la temperatura del dispositivo”.

Apple spiega poi come è stato ottimizzato questo framework per sfruttare al pieno CPU e GPU degli iPhone, sfruttando anche la grafica Metal e i BNNS (basic neural network subroutines). Anche l’utilizzo della memoria è stato ottimizzato per la gestione dei rilevamenti del volto e il caricamento in caching delle immagini.

Nel post viene confermato che gli ingegneri Apple hanno iniziato a lavorare al deep learning sul volto già in iOS 10.